Appleは大規模言語モデルをiPhone上でローカルに動作させることを目指している

Appleの研究者が「LLM in a flash: Efficient Large Language Model Inference with Limited Memory」と題した論文をプレプリントサーバーのarXivに公開しました。この論文では「メモリが限られたデバイス上で大規模言語モデル(LLM)の推論を効果的に行う道を開く解決策」、すなわちiPhoneなどのデバイス上でLLMを動作させるための技術が示されており、Appleは将来的にiPhone上でLLMを動作させることを目指していると考えられます。

[2312.11514] LLM in a flash: Efficient Large Language Model Inference with Limited Memory

https://arxiv.org/abs/2312.11514

Paper page - LLM in a flash: Efficient Large Language Model Inference with Limited Memory

https://huggingface.co/papers/2312.11514

Apple Develops Breakthrough Method for Running LLMs on iPhones - MacRumors

https://www.macrumors.com/2023/12/21/apple-ai-researchers-run-llms-iphones/

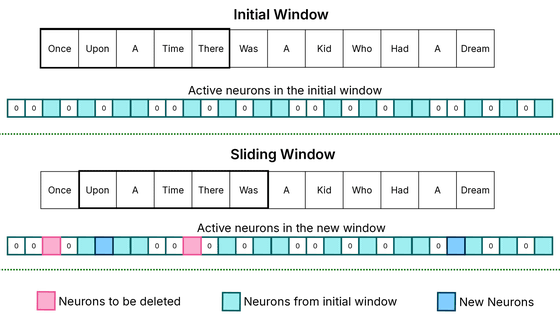

研究チームは論文の中で、スマートフォンなどのモバイルデバイスでは、従来LLMの実行に使われてきたRAMよりもフラッシュメモリストレージの方が豊富な容量を持つことに注目しています。そして「Windowing(ウィンドウ処理)」と「Row-Column Bundling(行列バンドル)」という2つの技術を使い、フラッシュメモリのスループットを最大化することを目指しています。

「ウィンドウ処理」とは、AIモデルが毎回新しいデータをロードするのではなく、すでに処理したデータの一部を再利用すること。これにより、メモリを定期的にフェッチする必要性が減り、プロセスがより高速かつスムーズになります。また、「行列バンドル」はフラッシュメモリのシーケンシャルデータアクセスにあわせてデータチャンクのサイズを増やす技術です。

Appleの研究チームによれば、「ウィンドウ処理」と「行列バンドル」の2つを組み合わせることで、利用可能なDRAMの最大2倍のサイズでAIモデルを実行できるようになるとのこと。その推論速度は、標準的なプロセッサにおいてCPUで行った場合の4~5倍、GPUで行った場合の20~25倍に匹敵するそうです。

本来データセンターで動作するようなLLMをスマートフォンなどのモバイルデバイスでローカルに動作させる試みはすでにGoogleが実用化段階に進めています。Googleは、マルチモーダルAIであるGeminiの最小サイズモデルである「Gemini Nano」をPixel 8 Proに導入し、クラウドではなくデバイス上で動くローカルAIとして動作させることを明らかにしています。

クラウド上ではなくスマホ上で動くローカルファーストLLM「Gemini Nano」がPixel 8 Proで動作可能に、GboardのSmart Replyとレコーダーの自動要約強化に先行投入 - GIGAZINE

一方、Appleは2011年からバーチャルアシスタント「Siri」をiPhoneをはじめとするAppleデバイスに搭載しています。ただし、Siriは昨今のChatGPTやBing Chat、Geminiのように人間らしい会話文を生成するチャットボットではなく、あくまでも音声入力による操作を可能にするアシスタントツールでしかありません。

「AppleはGoogleやMicrosoftにAI技術で遅れをとっている」とされていましたが、2023年に入ってAppleが独自に「Ajax」と呼ばれるLLMをすでに構築しており、「Apple GPT」と社内で呼ばれる独自のチャットボットAIを開発していることが報じられています。Apple関連ニュースサイトのMacRumorsによると、このAjaxはOpenAIのGPT-3あるいはGPT-4に匹敵するように設計されており、2000億のパラメーターで動作するとのこと。

Appleが独自の大規模言語モデルとチャットボットAI「Apple GPT」を開発中か - GIGAZINE

2023年11月にティム・クックCEOは、詳細を明らかにはしていないものの、「生成AIに関して、私たちは研究を進めています。そして、生成AIが中心となる製品をお披露目する時がいずれくるでしょう」と発言し、Appleが生成AI開発に着手していることを認めています。

Appleのティム・クックCEOが改めて「生成AIの開発に責任をもって取り組んでいる」と発言 - GIGAZINE

最終的にAppleの生成AIへの取り組みは、Siriに組み込まれる可能性があります。2023年10月には、すでにソフトウェアエンジニアリンググループがiOS 18にAI機能を搭載し、SiriとメッセージングアプリにLLMによる文章生成が応用されることが報じられています。また、生成AIをXcodeなどの開発ツールに統合することも検討されており、MicrosoftのGitHub Copilotのようにコードを書くときに自動補完してくれるコーディングサポートAIの導入も計画されているそうです。

また、海通国際証券のアナリストであるジェフ・プー氏は、Appleが2024年後半頃にリリースするであろうiOS 18に、iPhoneとiPadで利用可能な生成AI機能を搭載すると予想しています。プー氏によると、2023年10月にAppleはすでに数百台で構築されたAI用サーバーを準備しており、2024年にはさらに増築する予定だそうです。

今回発表された論文は、LLMをiPhone上で動作させることを想定したものといえます。研究チームは「今回のブレークスルーは、リソースが限られた環境に高度なLLMを導入し、適用性とアクセシビリティを拡大する場合に特に重要です。スパース性認識、コンテキスト適応型読み込み、およびハードウェア指向設計の統合により、メモリが限られたデバイス上でLLMを効果的に推論するための道が開かれます」とコメントしました。

・関連記事

iPhone上でAIが恋人になってくれるアプリ「Dolores」開発者がアプリの開発経緯と教訓を語る - GIGAZINE

Appleが画像生成AI「Stable Diffusion」にまさかの正式対応、開発者いわく「画像を1秒以内に生成可能」 - GIGAZINE

Appleのティム・クックCEOが独自の生成AIを開発中であると認める、Appleの研究開発費は前年同期より約4400億円も増加 - GIGAZINE

AppleはM2搭載iPad AirやA15 Bionic搭載iPad miniなどの新型モデルを2024年3月に発表か - GIGAZINE

・関連コンテンツ