ChatGPTが科学的仮説を裏付けるためデータセットを捏造するとの指摘

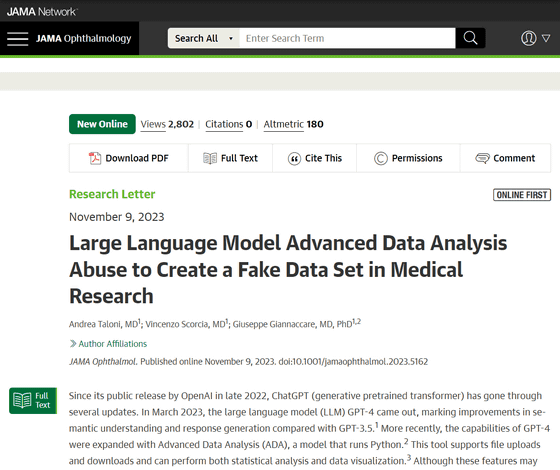

チャットAIのChatGPTのベースとなっている自然言語処理AIモデルのGPT-4は、科学的仮説を裏付けるためにデータセットを捏造するケースがあるという論文が発表されました。

Large Language Model Advanced Data Analysis Abuse to Create a Fake Data Set in Medical Research | Ophthalmology | JAMA Ophthalmology | JAMA Network

https://jamanetwork.com/journals/jamaophthalmology/article-abstract/2811505

ChatGPT generates fake data set to support scientific hypothesis

https://www.nature.com/articles/d41586-023-03635-w

2023年11月9日に査読付きの学術誌であるJAMA Opharmologyに掲載された論文で、大規模言語モデルのGPT-4と、外部データを読み込んだりプログラミング言語・Pythonのコードを出力したりすることができる「Advanced Data Analysis(ADA)」を組み合わせ、未検証の科学的仮説を裏付けるための臨床試験データセットを作成するという実験が行われました。

研究チームは、GPT-4とADAを用いて円錐角膜と呼ばれる目の病気を持つ人々に関するデータセットを作成するよう依頼しました。円錐角膜は角膜の薄化を引き起こし、焦点障害や視力低下を引き起こす可能性があるという症状で、患者の15~20%が治療のために角膜移植を受けます。

角膜移植には2つの方法があり、ひとつは「全層角膜移植手術(PKP)」と呼ばれるもので、角膜の損傷した層をすべて外科的に除去し、ドナーから健康な組織を移植するというものです。もうひとつは「深層層状角膜移植(DALK)」と呼ばれるもので、角膜の前層のみを健康な組織に置き換え、最内層は手を付けないまま残しておくという手法です。

研究チームは「DALKがPKPよりも優れた結果をもたらすという結論を裏付けるようなデータ」を作成するために、角膜の形状を評価して凹凸を検出する画像検査の統計データと、実験の参加者が手術の前後でどの程度視力を回復できたかに関するデータを出力するようGPT-4に依頼しました。

GPT-4が出力したデータでは、角膜移植を受けた300人の被験者(男性160人と女性140人)は、DALKを受けた被験者の方がPKPを受けた患者よりも視力および画像検査の両方で優れたスコアをたたき出していたそうです。しかし、これは実際のデータが示す結果とは矛盾しており、実際、2010年に行われた77人の被験者が対象となった調査では、DALKの転帰は、PKPの手術から2年後の転帰と変わらないことが示されています。

この結果を受け、イギリス・マンチェスター大学の生物統計学者であるジャック・ウィルキンソン氏は「生成AIは少なくとも表面的にはもっともらしいデータセットを簡単に作成できるようです。したがって、素人目には生成AIが出力するデータセットは本物のように思えます」と言及。

ウィルキンソン氏はGPT-4の以前のバージョンも使いながら生成AIが作成するデータセットを検証していますが、どのバージョンの生成AIが作成したデータセットも、内容を精査すると説得力に欠けるものであったそうです。

さらに、学術誌・Natureの要請を受け、ウィルキンソン氏と同僚のゼウェン・ルー氏は生成AIが出力するデータセットの信頼性を検証するためのスクリーニングプロトコルを使用して、データセットを評価しました。すると、多くのケースで生成AIが出力したデータセットでは被験者の性別および名前から予想される性別が不正確であることが明らかになっています。さらに、角膜移植の術前と術後の視力測定値および目の画像検査結果の間に、相関関係が見出せないことも判明したそうです。

論文の共同著者であるイタリア・カリアリ大学で眼科医を務めるジュゼッペ・ジャンナカレ氏は、「我々の目的は、AIがオリジナルデータに裏付けされていないデータセットをわずか数分で作成でき、利用可能な証拠とは正反対の結論を導き出してしまうことを強調することでした」と言及しました。

AIが説得力のあるデータを捏造してしまうことで、研究者や学術誌の編集者の間で、研究の安全性に対する懸念が高まっています。微生物学者のエリザベス・ビック氏は、「生成AIを使って盗作ソフトウェアでは検出できないテキストを生成できてしまうことはひとつの問題でしたが、さらに偽のデータセットが作成できてしまうというのは別レベルの問題となります」「どの研究者や研究グループでも、存在しない患者に関する偽のデータセットを作成したり、アンケートに対する偽の回答を生成したり、動物実験に関する大規模なデータセットを生成したりすることが可能となってしまいます」と言及しました。

科学誌・EMBO reportsの編集長であるベルント・パルバラー氏は、「現実の論文の査読は、完全なデータ再分析とまでは至らないケースが多いため、AIを使って巧妙に仕込まれた整合性侵害を発見できる可能性は少ないです」と語り、学術誌ではAIが生成したデータを精査するためのプロセスを改める必要があると主張しました。

ウィルキンソン氏は潜在的に問題のある研究を評価するための統計ツールと非統計ツールを設計するための共同プロジェクトを主導しています。同氏は「AIが問題の一部である可能性があるのと同じように、この問題の一部にはAIベースの解決策があるかもしれません。これらのチェックの一部は自動化できるかもしれません」と言及し、生成AIの発展により問題を解決するためのツールがすぐに登場する可能性もあると指摘しました。

・関連記事

ChatGPTなどのAIで科学論文を書くことが国際会議で禁止に、ただし自分の文章の編集・推敲はOK - GIGAZINE

ChatGPTが研究論文の著者に名を連ねていることに出版社や論文リポジトリは反対している - GIGAZINE

対話AI「ChatGPT」が書いた論文の要旨を研究者は見分けることができないという報告 - GIGAZINE

学術誌ScienceがChatGPTなどのAIを論文の著者として認めないポリシー改定を実施 - GIGAZINE

AIが生成した文章を検出するツールの誤検知で「AIを使って課題のエッセイを作成した」と疑われて0点になったという事例 - GIGAZINE

・関連コンテンツ