8月2日、Artificial Analysisが「 LLM Leaderboard 」と題したWebサイトを公開した。

このページでは近年急速に注目を集めているLLMや画像生成モデルなどを横断的に比較できることができる。

LLM Leaderboardとは

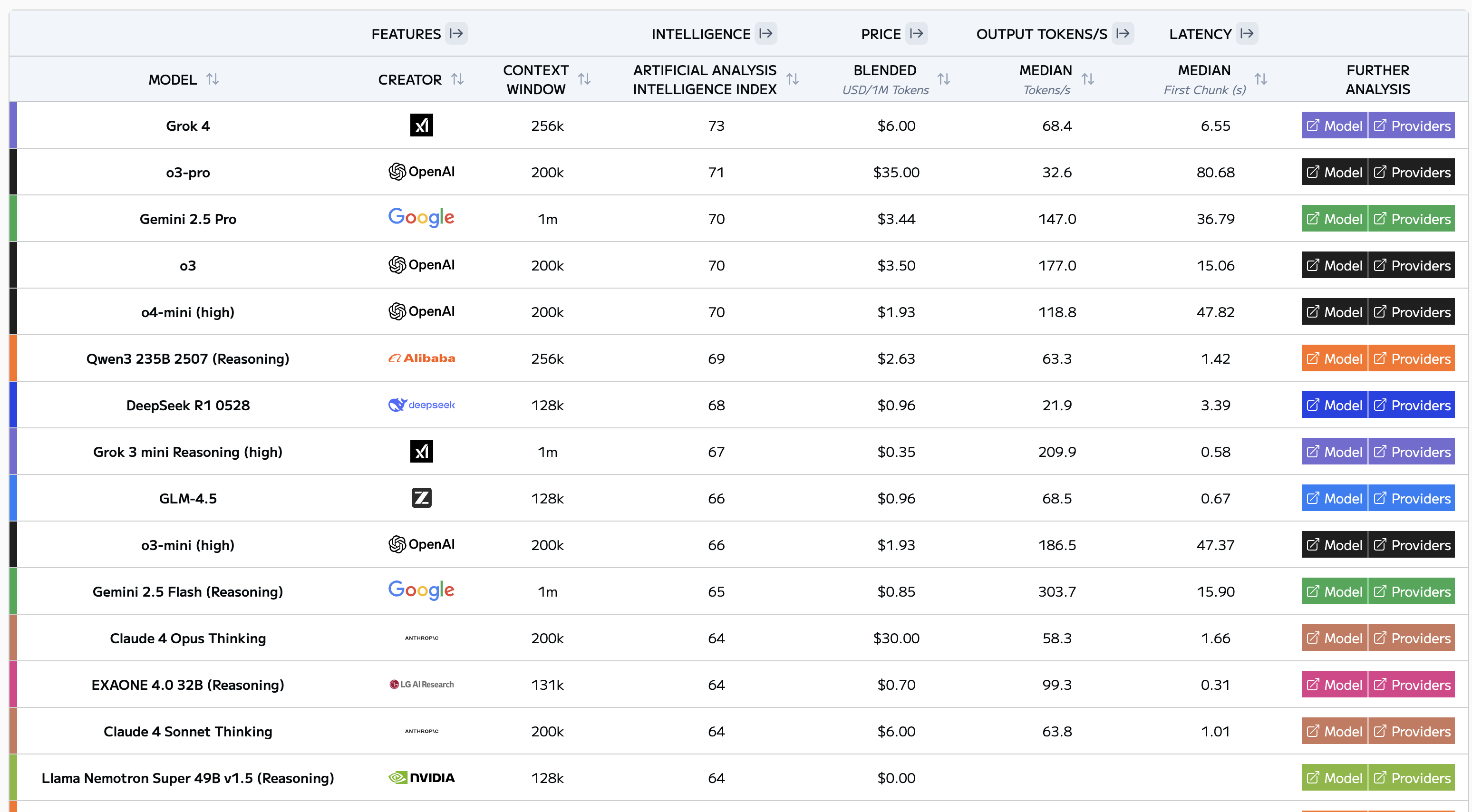

LLM Leaderboardは、LLM・画像・音声・コード生成・検索エンジンといった複数カテゴリの最新モデルを一覧にしている。

各モデルは以下のような軸で評価されており、絞り込みや並べ替えも自在に行える。

- 標準ベンチマーク(例:MMLU, GSM-8K, HumanEval など)

- パラメータ数/コンテキスト長/ライセンス

- API 料金や推論速度

- 最新アップデート日時

一覧の各行にはHugging Faceや論文、公式 GitHubへのリンクが埋め込まれており、「スコアを確認 → 実モデルを試す」までがページ内で完結する設計になっている。データは日次で自動更新され、過去スナップショットも保持されるため、モデルの伸びを時系列で追跡できるのも強みだ。

(現時点での)LLM比較ハイライト

- 知能: Grok 4 と o3-pro は 最もインテリジェンスの高いモデルであり、次にGemini 2.5 Proとo3が続く。

- 出力速度(トークン/秒): 最速のモデルはGemini 2.5 Flash-Lite (Reasoning) (643 t/s) と Nova Microのロゴ Nova Micro (374 t/s)で、これにGemini 2.5 Flash-LiteとGemini 2.5 Flash (Reasoning)が続く。

- レイテンシ(秒): Aya Expanse 8B (0.14 秒) と Command-R (2024 年 3 月) (0.14 秒) が最もレイテンシが低いモデルであり、次にLFM 40BとAya Expanse 32Bが続く。

- 価格(Mトークンあたり$) : Gemma 3n E4B (0.03 ドル) と ジェマ3 4Bロゴ Gemma 3 4B (0.03 ドル)で、次にLlama 3.2 3BとMinistral 3Bが続く。

- コンテキストウィンドウ: Llama 4 Scout (10m) と MiniMax-Text-01 (4m) が最大のコンテキストウィンドウモデルであり、これにGemini 2.0 Pro ExperimentalとGemini 1.5 Pro (Sep)が続く。

まとめ

社内PoCや新規プロダクトで「どの LLM を使うべきか」迷う場面は多い。Artificial Analysis なら精度・推論コスト・ライセンスをワンストップで比較できるため、GitHub や論文を一つずつ探し回る手間が省ける。モデル選定の初動コストを大幅に削減できる だろう。

またページは日次で自動更新されるため、動きの速いAIの進化に追随するのに役立つ。Slack の RSS 連携や Zapier での通知設定も推奨されており、常に最新性能をウォッチできる。

詳細はLLM Leaderboardを参照していただきたい。