ここ最近、生成AIに要約などのURLを指定した参照処理ができない事が増えたので、それについての雑記です。

(雑記なので、専門的な調査や論考ではありません。もし、間違ってるところがあったら指摘は歓迎です。修正しますので優しく教えてください。)

なお、本記事は心を込めて物理キーボードを叩いて書いた人間の手作りです(一部データ集計などAIに手伝ってもらってるはいるけど)ので、どうぞ安心して最後までお読みください。AIに書いてもらえなかったオチがあります。

下の画像は ChatGPT に NHKのニュースにアクセスしてもらおうとして「robots.txtで禁止されている」という理由で断られてるところ。生成AI系から記事へのアクセスができなくなっている。

どうも最近は robots.txtで生成AIからのアクセスをブロックしてるメディアが増えているみたい。

robots.txtはクローラー(ロボット)に向けの指示書みたいなもの。「どのページはアクセスしてよいか」や「どこから先はアクセス禁止か」などを伝えることができる。

ただし、お行儀の良い(RFC 準拠の)クローラーしか指示を守ってくれないため、お行儀の悪いクローラーには意味がない。特に法的な拘束力があるわけでもない。

大手メディアのrobots.txt(2025年4月27日時点)はこんな感じ。

メディア名をクリックするとrobots.txtに遷移します。

| User-Agent | NHK | 毎日新聞 | 産経新聞 | 朝日新聞 | 読売新聞 | 日経新聞 | ヤフーニュース | TBS NEWS DIG |

|---|---|---|---|---|---|---|---|---|

| GPTBot | × | × | × | × | × | × | × | × |

| ChatGPT-User | × | × | × | × | × | × | × | × |

| Google-Extended | × | × | × | × | × | × | × | × |

| ClaudeBot | × | × | × | × | × | × | × | |

| Claude-Web | × | × | × | × | × | × | ||

| PerplexityBot | × | × | × | × | × | × | × | |

| Perplexity-ai | × | × | × | × | × | × | ||

| Applebot-Extended | × | × | × | × | × | × | × | |

| CCBot | × | × | × | × | × | × | × | × |

| OAI-SearchBot | × | × | × | × | × | × | ||

| anthropic-ai | × | × | × | × | × | × | × | |

| cohere-ai | × | × | × | × | × | × | × | |

| ICC-Crawler | × | × | × | × | × | × | ||

| Bytespider | × | × | × | × | ||||

| Meta-ExternalAgent | × | × | × | × | × | × | × |

日経新聞は「商用利用や大規模学習するなら、データ買ってね」と呼びかけるようにURL入りのコメントしてる。こういうの好感持てるなあ。

# If you want to use our data in machine learning, please contact us from the following url.

# ja: https://nkbb.nikkei.co.jp/alternative/article_data/

# en: https://nkbb.nikkei.co.jp/en/dataset/nikkei-news-articles

サイト丸ごとにルールを設定するrobots.txtではなく、ページ単位で設定できるX-Robots-Tag: noai を活用してるサイトを探してみたけど、今のところはまだないような気がする。あったら知りたい。

「はてなブログ」も生成AIが参照できなくなっていた。

このブログは「はてなブログ」を利用しているのだけれど、生成AIが読んでくれなくなっていた。

ぼくの書いた記事中に「パイナップル」という語が何回出てくるか数えてもらおうとしたら断られたのだ。これ管理画面で設定できるようにならんかな。

noteは、AIウェルカムな姿勢で、ほぼノーガードに見える。

管理画面に「AI学習に対してオプトアウト意向を示す」っていう謎のスイッチがあるんだけど、機能をオンにしても何も起きていない(よね?)。

この機能、いつから有効になるんだろう…

| User-Agent | note.com | はてなブログ | はてな匿名ダイアリー |

|---|---|---|---|

| GPTBot | ✗ | ✗ | |

| ChatGPT-User | ✗ | ✗ | |

| Google-Extended | ✗ | ✗ | |

| ClaudeBot / Web | ✗ | ✗ | |

| PerplexityBot / ai | ✗ | ✗ | |

| Applebot-Extended | ✗ | ✗ | |

| CCBot | ✗ | ✗ | |

| anthropic-ai | ✗ | ✗ | |

| cohere-ai | ✗ | ✗ | |

| ICC-Crawler | ✗ | ✗ | |

| Bytespider | ✗ | ✗ | |

| Perplexity-ai | ✗ | ✗ |

生成AIがブロックされるのは仕方ないような、不便のような……

これまでのGoogleなどの検索エンジンのクローラーなら、インデックスされることで自サイトへの流入が増える可能性が高かったから、検索エンジンのクローラーが訪れることは歓迎されていた。

でも、生成AIがチャット上で記事の内容をすべて説明してしまうと、元ネタが書いてあるサイトに来るはずだったアクセスが奪われてしまう(いくら参考リンクがあるとはいえ、アクセスされなくなることは間違いないよね)。

それで、各社生成AI系のクローラーを蹴るのが普通になってきてる。

ユーザーがAIに訊いて満足してしまうとサイトに訪問しなくなる → つまり、各メディアがコストをかけて作った記事をAIが処理しちゃうと自社サイトにアクセスが来なくなるから、コストをかけられなくなる → 記事を作れなくなる可能性がある。

これは「学習」として語られることが多いけど、「参照」処理も同様なんだよな〜。

生成AI系のクローラーが訪れることが事業的マイナスしかないのだったら、WebサイトはAIをブロックする方が経済合理性があるし、そうしないとメディアが持続的に記事を作ることができないからユーザーやAI企業にとっても損失ということになる。今のところブロックするのは合理的な判断なんだろう。ちょっと不便だけど……

今は便利なDeep Researchや、これから期待されているAIエージェントなんかも影響あるよね……

まだ大手メディアや、はてなのようなごく一部の企業だけがブロックしてるけれど、情報発信側が生成AI系クローラーにアクセスされるメリットがなければ、これからジワジワと生成AIの情報源は減っていく可能性がある(まだ、そうなると断定できる段階にはないけれど)。

今はとても便利なDeep Researchも、これから数年かけて生成AIがネタ元にできる情報が限られてしまうのであれば、欲しい結果が得られなくなってしまう可能性はあるよね。

これから期待されているAIエージェントについても、「やり方を自分で調べて動く」みたいなことが期待されていると思うんだけど、生成AIが判断に使う情報源が限られてしまうとちょっと使いづらくなるかもしれない。

そうなると生成AIというものの情報処理能力が信頼できないものになったりしないだろうか。心配しすぎかな?心配だなあ。

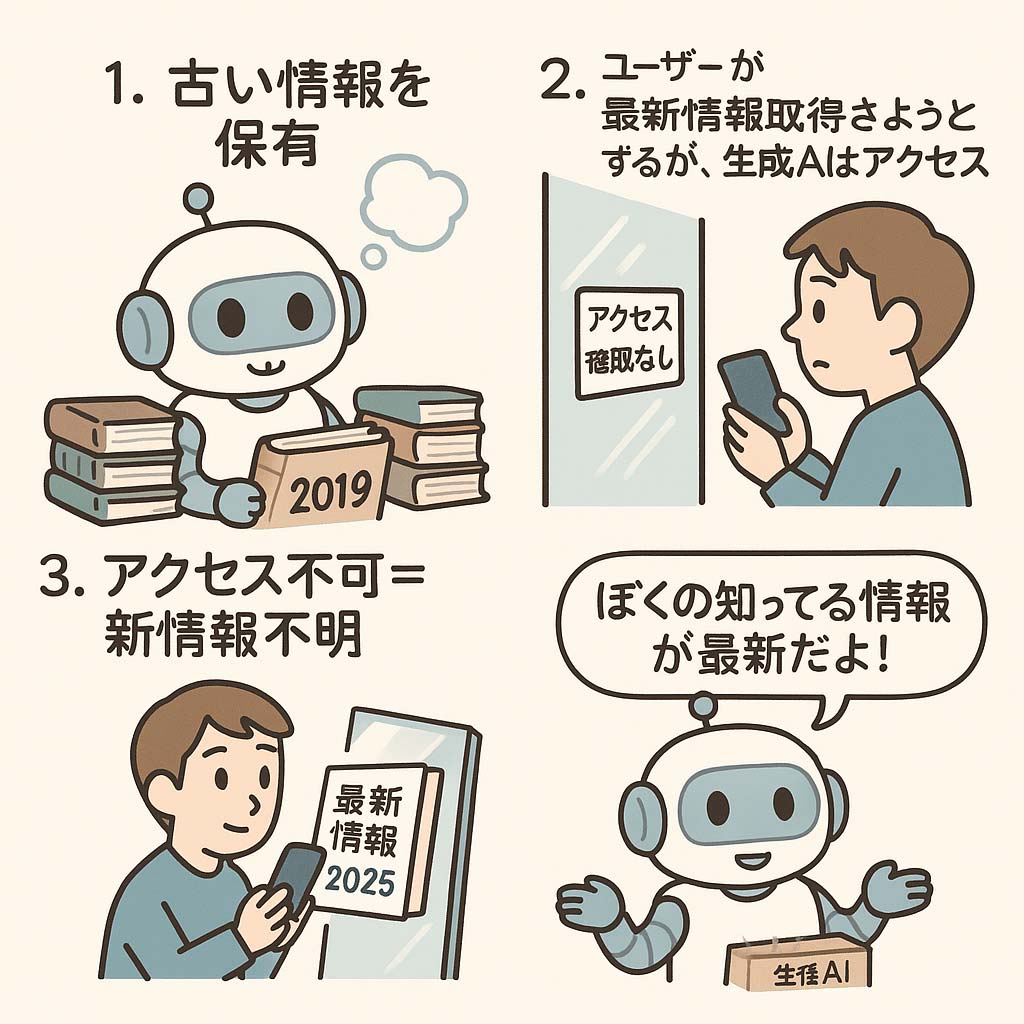

最新情報を参照できないことでハルシネーションが起きやすくなる。

新たにアクセスすることができなくても、生成AIは以前から覚えている記事について思い出すことはできるんだけど、これはこれで問題がある。

内容が更新されているのに古い情報のまま「これが最新です」と言い張ってきたり、AIが情報を持っていないことでもっともらしく誤った回答を生成してしまう現象が多発するんですよね。

人間から見ると「最新情報を参照して」とプロンプトを入れているから、AIが古い情報で喋っていることに気がつけない。

URLを渡してるのに、参照処理ができないから「こんなことが書いてあります」と書かれていないことを出力するようなハルシネーションも頻繁に起きるようになる。

いま書いてるこの記事も生成AIに下書きをさせようとしてみたのだけれど、生成AIが記憶している古いrobots.txtを最新情報だと勘違いして書こうとしてくるので、仕方なく手書きで書いているのです……。

最新情報を記事にしたい

→ アクセス禁止で情報が更新できない

→ AIからはアクセスできないのではなく、最新情報はないように見えてしまう(実際に見えてないから)

→ AIは自分が持っている情報が最新だと判断する

……みたいな感じ。SF小説にできそうだよね、これ。

まあ、生成AI各社も最新情報にアクセスできなくなった生成AIでも変なことを言わないようにはしたいだろうし、しばらくしたら対策されるのかもしれないけどね。

生成AIに利用される情報を作っている人や企業が損をしない「健康的で持続可能な情報流通」が社会実装されて欲しい。

これまでは、Googleのような検索エンジンがクロール・インデックスしてきても検索経由のトラフィック増加を見込めるから歓迎されていたけれど、生成AIの場合は自コンテンツが利用されるだけで損することが多いわけだから、同じようにはいかない。これが解決しない限りはAIブロックするWebサイトは報道機関だけじゃなく、企業のオウンドメディアとかお役立ちコンテンツ全般にも広がっていくんじゃないだろか。

検索のような「検索経由で閲覧が増えるんだからクロール・インデックスさせてね」というモデルではなく、Googleが報道機関に対して記事の使用料やライセンス料を支払っている「Googleニュースショーケース」のような仕組みを生成AI各社もやれば良いのかもしれない(EUはそういう動きっぽい?)。

もし、そんなふうになったら生成AIの利用料金がハネ上がるのかもしれない。

生成AIの場合は、「Googleニュースショーケース」のような報道機関だけの問題ではなく、あらゆる「情報を作っている人や企業」が対象になるから、金を払えば良いという簡単な話でもないような気もしている。むつかしい。

いまの日本の法律だと機械的な情報解析目的なら処理して良いことになっているけれど、情報を作っている人や企業が損をせずにAI活用が推進される「健康的で持続可能な情報流通」が設計されないといけなくなるんじゃないかなあと思う今日このごろです。いや、ぼくも「こうあるべき」って言うほどの意見はもっていないんだけどね。

以上、雑記でした。

追記:

この記事のURLです。