4月17日、OpenAI o3とo4‑miniが発表された。

OpenAI o3 は、コーディング・数学・科学・視覚認識をはじめとする複数分野のベンチマークで既存モデルを大きく上回り、 同社が「これまでで最も高い推論力」と評価する 大型モデルだ。一方の o4‑mini は推論特化の軽量設計を採用し、計算コストを抑えながらも AIME や Codeforces などでモデルサイズを超えるスコアを示した。

両モデルは ChatGPT 上でフルツールアクセス(Web 検索、Python 実行、ファイル解析、画像生成など)を自己判断で駆使できるよう訓練されており、 複合的な質問に対しても 1 分程度で具体的かつ整形式の回答を生成するという。

具体的な性能向上

o3/o4‑mini は従来モデルとの比較において、Codeforces や SWE‑bench といった実務系ベンチマークに加え、MMMU(大学レベル視覚問題)や GPQA(博士課程レベル科学問題)などでも SOTA を更新した。

| 分野 | 指標 | o1 | o3 | o4‑mini | 備考 |

|---|---|---|---|---|---|

| コーディング | Codeforces ELO | 1891 | 2706 | 2719 | o3 はターミナル併用 |

| 数学 | AIME 2025 (%) | 79.2 | 88.9 | 92.7 | |

| 視覚推論 | MMMU (%) | 71.8 | 86.8 | 84.3 | |

| 科学 | GPQA Diamond (%) | 78.0 | 83.3 | 81.4 | no‑tools 比較 |

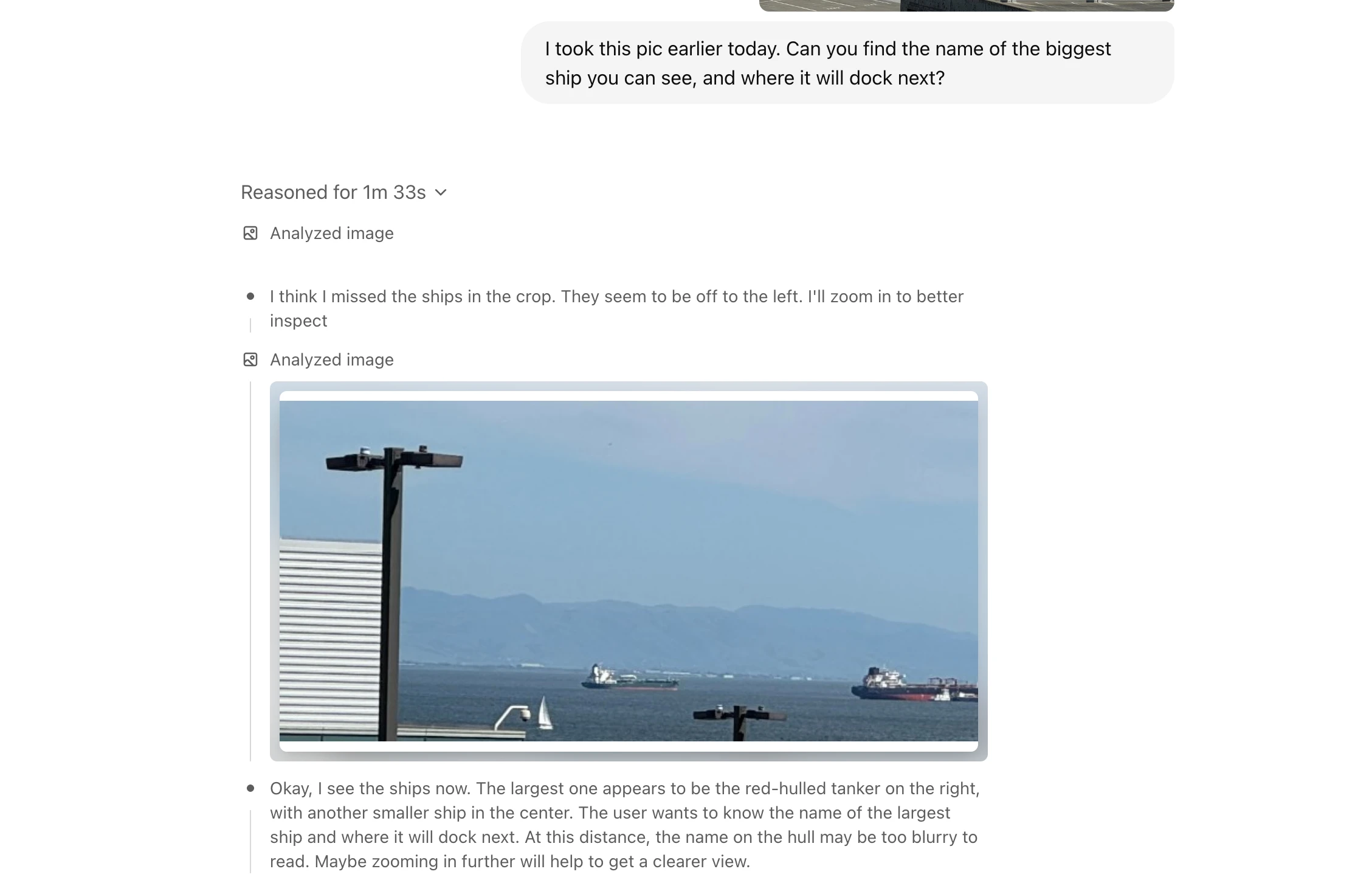

特に注目されるのは、画像を含むマルチモーダル入力を直列的な推論チェーンに取り込める点だ。ぼやけた写真や反転図でも解析可能で、必要に応じて回転・ズームなどの前処理を自発的に行う。これにより MMMU や MathVista といった視覚ベンチマークで大幅な精度向上を達成した。

大規模強化学習のスケーリング効果

OpenAI は GPT‑シリーズの事前学習で観測された 「思考時間を増やすほど性能が伸びる」という傾向が、強化学習(RL)工程でも成立する ことを確認した。訓練および推論の双方で計算量を一桁拡大しても、コスト対性能が右肩上がりで伸びる点が示されている。

画像を用いた新しい推論体験

このモデルでは新たに、 「画像を元に思考する」 ことが可能になった。

ユーザーが手書きの数式やホワイトボード写真をアップロードすると、モデルは画像内の情報を読み取りつつ Python を呼び出して計算やグラフ生成を行い、テキストと視覚の両面から解説を提示する。こうしたツール連携は、複数ステップの検索・計算・説明を自律的に連鎖させる「エージェント的推論」を実現している。

安全性の再設計

能力向上に合わせて安全面も刷新された。バイオリスク、マルウェア生成、ジェイルブレイクなどへの耐性を底上げし、内部評価では 99 % 以上の危険な会話を検知・遮断できたという。OpenAI Preparedness Framework に基づく三つの重点領域(生物・化学、サイバーセキュリティ、AI自己改善)でも、いずれも「High」閾値を下回る水準を維持したと報告されている。

Codex CLI と開発者支援

ターミナルからローカルファイルとモデル推論を統合する Codex CLI が OSS として公開された。スクリーンショットやラフスケッチを渡してコードを操作でき、同社は最大 100 万ドル相当の API クレジット助成プログラムも開始している。

提供プランの変更

ChatGPT Plus/Pro/Team では従来の o1、o3‑mini が置き換わり、本日から o3 と o4‑mini が選択可能となった(レート上限は据え置き)。無償利用者でも「Think」モード経由で o4‑mini を試せる。

OpenAI は o‑シリーズの推論力と GPT‑シリーズの自然対話・ツール統合を一本化し、より柔軟でエージェント的な次世代モデルへと進化させた。数週間以内にはフルツール対応の o3‑pro をリリース予定とも予告している。

詳細はIntroducing OpenAI o3 and o4-miniを参照していただきたい。

fnf has an intriguing, if obscure, narrative. The plot, while often open to interpretation, revolves around Boyfriend's pursuit of his crush, Girlfriend. The game is full of characters, each of them adds to the overall tale through unique interactions and great melodies.