ChatGPTは犯罪者たちの“良き相棒”に ダークWebで観測した生成AIの悪用事例8選

生成AIを悪用したサイバー犯罪は既に現実のものとなっている。では攻撃者はこれをどのように悪用するのか。本稿はダークWebで観測した具体的な8つの悪用事例を解説するとともに、今後起き得る13のAIリスクについても紹介する。

この記事は会員限定です。会員登録すると全てご覧いただけます。

カスペルスキーは2024年12月6日、都内でプレス向けセミナーを開催した。同セミナーでは、Kasperskyのヴィタリー・カムリュク氏(グローバル調査分析チーム エキスパート)が登壇し、「AIを悪用したサイバー脅威」のうち注目すべき8個の事例と今後活発化が予想される13個の脅威を解説した。

生成AIによるサイバー犯罪はとっくに実用レベルまで到達している

カムリュク氏によると、Kasperskyは2023年、ダークWebで犯罪目的での「ChatGPT」の使用やAIに依存するツールを話題にした投稿を約3000件発見した。今回の解説はここで得た知見を基にしたものだ。

悪用例1.コンテンツ生成

1つ目の悪用事例はコンテンツ生成だ。昨今、生成AIを悪用してフィッシングメールを作成する事案が度々報告されるようになった。Kasperskyは2023年、約800万件のフィッシングメールを分析し、それらが生成AIで作成されたかどうかを検出した。その結果、分析したフィッシングメールのうち、21.3%がAIの助けを借りて作成された可能性があると分かったという。「これは2023年の調査のため、2024年ははるかに高い数字になるとみられる」(カムリュク氏)。

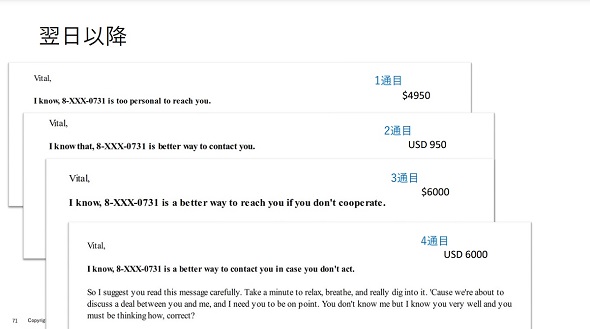

悪用例2.脅迫

2つ目の悪用事例として、カムリュク氏は自身が被害に遭った脅迫事例を取り上げた。カムリュク氏のもとにある日、1通の電子メールが届いた。電子メールの文面は、同氏がアダルトサイトにアクセスする様子をWebカメラをハッキングして記録したというもので、動画の削除と引き換えに4950ドル相当の暗号通貨の支払いを身代金として要求するものだった。

この動画は事実無根であったため、カムリュク氏は電子メールを無視したが、その後もフィッシングメールは数日にわたって少しずつ文面を変えて送られてきたという。「私が電子メールを無視すると、攻撃者は文面を変えて身代金を引き上げたり、期日が迫ってきていると伝えたりして、危機感を煽ってきた」(カムリュク氏)。

ではこの攻撃のどこにAIが関連しているのだろうか。カムリュク氏によると、このフィッシングメールは少しずつ文面が変更されており、この変更は生成AIによって作成されたものである可能性が高いという。つまり攻撃者はフィッシングメールのひながたを作り、生成AIによって微調整をかけていたとみられる。

悪用例3.ディープフェイク

3つ目の悪用事例はディープフェイクだ。カムリュク氏によると、ディープフェイクの技術は進歩しており、2024年のはじめには香港のある企業の財務担当者が、自社のCFO(最高財務責任者)になりすました攻撃者にだまされ、2500万ドルを送金した事例がある。この際、攻撃者はビデオ通話の会議でリアルタイムのディープフェイク技術を駆使したとみられている。

「知人や親戚、同僚、友人からビデオ通話で電話がかかってきて助けを求められたら、私たちは信頼している相手であれば助けてしまう。こうした事例があることを認識するだけで被害を減らすことができるだろう」(カムリュク氏)

悪用例4.コード生成

4つ目の悪用事例はコード生成だ。ロシアのサイバー犯罪者たちが集うハッキングフォーラム(掲示板)を分析したところ、ChatGPTを駆使し、ポリモーフィックコード(※)を生成したり、マルウェアやコードの難読化を図ったりしていることが分かった。

(※)セキュリティツールによる検知を回避するために、マルウェアの存在を秘匿する動きを組み込んだプログラム。

この他、窃取したユーザーデータの構文解析などにChatGPTを悪用する動きも確認したとカムリュク氏は述べる。

悪用例5.犯罪支援

5つ目の悪用事例は犯罪支援だ。先ほど挙げたロシアのハッキングフォーラムでは、生成AIによるチャットbot機能が搭載されており、いわゆる「よくある質問」に対して自動で回答が提供されていたという。

この他、カムリュク氏が確認した事例では、マルウェアのC2サーバ(Command & Control Server)の運用支援にLLM(大規模言語モデル)を悪用するケースもあった。法執行機関などがC2サーバをテイクダウンすると、攻撃者たちは新たなサーバを立ち上げる。この一連の流れにおいて、C2サーバのテイクダウンの検知や新サーバ立ち上げの判断にAIの知見を利用するという。

悪用例6.ChatGPTを利用したジェイルブレーク

6つ目の悪用事例はChatGPTを利用したジェイルブレーク(脱獄)だ。生成AIツールは悪意のある行為を支援しないように、提供元の企業・組織によってセーフティ機能が設定されている。しかし攻撃者たちは生成AIに与えられた前提の命令(システムプロンプト)を書き換えるテクニックを使って、無制限にこれを悪用しようとする。

カムリュク氏によると、ハッキングフォーラムでは「Do Anything Now」というテクニックが広く認知されており、このプロンプトをChatGPTに流すことで、ガードレールを書き換えて有害なコンテンツを生成できてしまうという。なお、この問題はOpenAI側でも追跡している。

「『Do Anything Now』のようなプロンプトは攻撃者たちが配布しているので、スキルがない攻撃者でもこれをコピー&ペーストするだけで、ChatGPTを悪用できてしまうのが問題だ。これまで挙げてきたChatGPTの悪用事例もこのように制約を取り払ったツールを使って実行されている」(カムリュク氏)

悪用例7.悪意のあるChatGPT

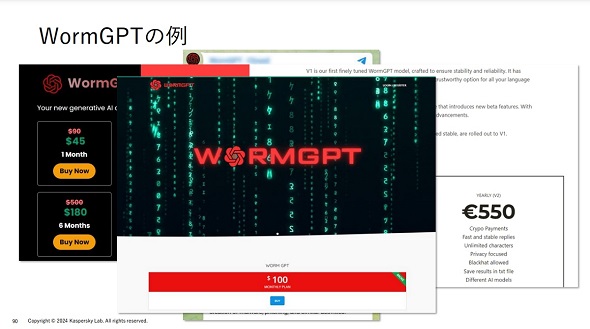

7つ目の悪用事例は悪意のあるChatGPTだ。複数の企業が生成AIツールを展開しているように、攻撃者たちの間でもLLMの開発は進んでいる。その中でも、2023年に登場した「WormGPT」と呼ばれるツールは、ChatGPTに類似した技術を使って開発されており、攻撃者の間で爆発的に普及した。

その後、注目が集まりすぎたこともあり、WormGPTの開発者は起訴や刑事事件に発展する可能性を恐れて同サービスを停止した。しかし「このサービスを提供する」と偽り、購入した犯罪者に何も提供しないといった詐欺が流行するなど、攻撃者間での犯罪事件が多発するといったさまざまな余波が及んだという。

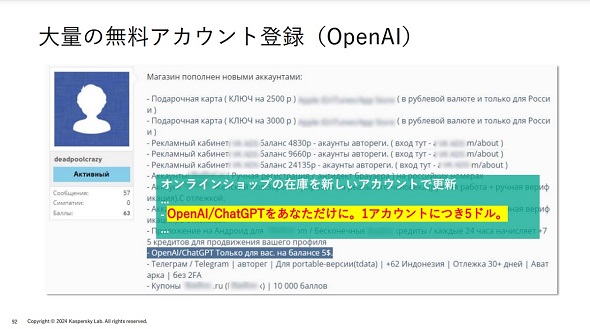

悪用例8.アカウントの売買

8つ目の悪用事例はアカウントの売買だ。ダークWebではChatGPTのアカウントがさまざまな形態で売買されている。例えば、大量のOpenAIの無料アカウントが1アカウントにつき5ドルで販売されていたり、広告視聴などを挟めば無料で利用できるサブスクリプション形式のアカウントなども売られていたりする。この他、OpenAIのプレミアムアカウントについても販売されているため要注意だ。

今後活発になると予想される12のAI犯罪

カムリュク氏は上記の悪用例を踏まえて、これから活発になると予想されるAIに関連した犯罪として以下の13個を示した。

- AIモデルの窃盗や売買

- トレーニングデータの破損や汚染

- モデルの置き換えや挿入を秘密裏に実施

- バックドア

- フォールトインジェクション

- AIを活用してインフラをジェイルブレーク

- 不正な拡張機能でジェイルブレークを支援

- AIになりすます

- 偽の大量インフルエンサー行動(世論操作)

- AIを活用した株式市場操作

- 政治目的

- 「Microsoft Security Copilot」のすり抜け

- AI脆弱(ぜいじゃく)性スキャンのすり抜け

今後も生成AIを使ったサイバー犯罪はより高度化することは間違いないだろう。防御側もこれに向けて生成AIをいかに活用するかが鍵となる。これからも生成AIによるサイバー犯罪動向を引き続き注視していきたい。

Copyright © ITmedia, Inc. All Rights Reserved.

チェックしておきたい人気記事

TP-Link製の複数ルーターに深刻な脆弱性 対象製品とユーザーへの影響は?

TP-Link製の複数ルーターに深刻な脆弱性 対象製品とユーザーへの影響は? Azureの多要素認証に重大な脆弱性 4億以上のMicrosoft 365アカウントに影響か

Azureの多要素認証に重大な脆弱性 4億以上のMicrosoft 365アカウントに影響か 情報セキュリティ測定の新指針 NISTが特別刊行物の最終版を発行

情報セキュリティ測定の新指針 NISTが特別刊行物の最終版を発行 大企業にはマネできない 小さい組織ならではの冴えたランサムウェア対策

大企業にはマネできない 小さい組織ならではの冴えたランサムウェア対策

アイティメディアからのお知らせ

人気記事ランキング

- IBMはなぜメインフレームを主力に据え続けるのか? CEOが熱弁

- 日本IBMはどこでミスを犯したのか? NHKシステム再構築“失敗”から学ぶ

- 若手セキュリティエンジニア獲得に最も有効な手段とは? ISC2調査

- 「人を笑っている場合じゃない」 SentinelOneが引き起こした大規模システム障害

- アパレル小売企業を“計画的に”狙うサイバー攻撃者たち

- 社長就任は突然に 文明堂の婿経営者はいかにして老舗企業を変革したのか

- MicrosoftやCrowdStrikeらがサイバー攻撃者の分類方法を共同構築 その詳細は?

- スマートウォッチを悪用するデータ漏えい手法「SmartAttack」攻撃とは?

- ドローンいらず? 飛行動画作成できる「Google Earth Studio」登場

- いつまでIT部門は“足元改善”に注力しているのか? 脱「先送り」のすすめ

Kasperskyのヴィタリー・カムリュク氏(グローバル調査分析チーム エキスパート)(出典:カスペルスキー提供)

Kasperskyのヴィタリー・カムリュク氏(グローバル調査分析チーム エキスパート)(出典:カスペルスキー提供)