1月20日、Alan W. Smith氏が「Fix Your robots.txt or Your Site Disappears from Google」と題した記事を公開し、話題を呼んでいる。この記事では、robots.txtファイルへのアクセス不可が原因で、ウェブサイトがGoogleの検索結果から完全に消失するリスクと、その技術的な背景について詳しく紹介されている。

以下に、その内容を紹介する。

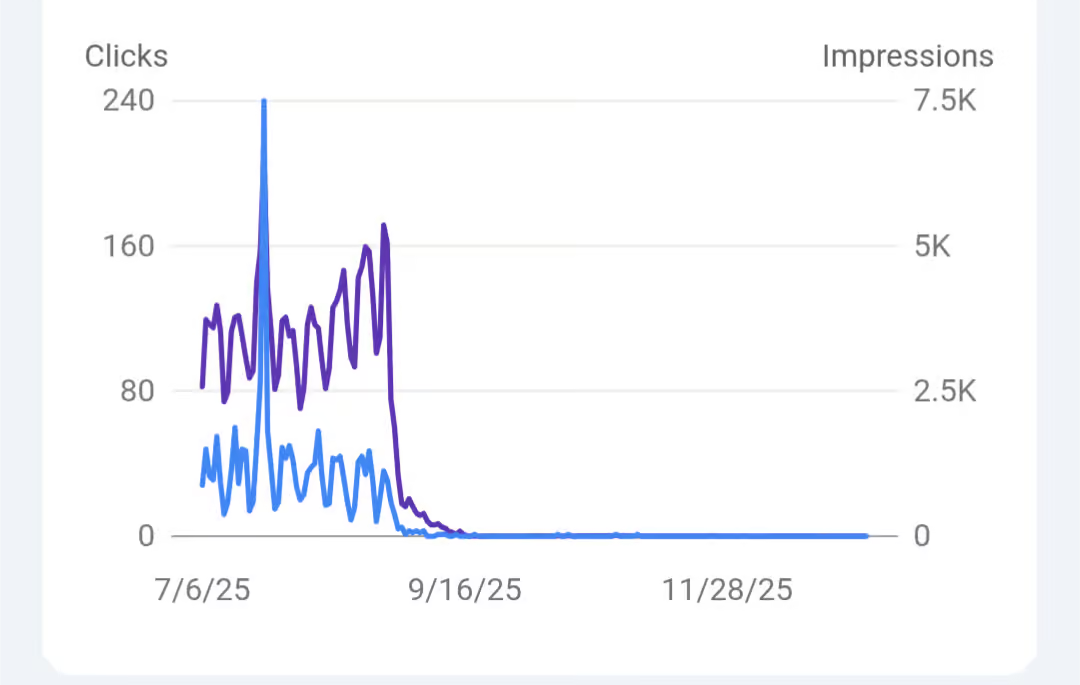

エンジニアのAdam Coster氏は、自身のウェブサイトのトラフィックに異常な問題が発生していることに気づき、その状況をDiscord上で公開した。Googleからの流入を示すグラフ(下図)を確認すると、2025年8月中旬を境にクリック数とインプレッション数が突如としてゼロに転じていることがわかる。

調査の結果、この問題の核心は「単にrobots.txtが存在しないこと」ではなく、「Googlebotがrobots.txtにアクセスしようとした際にエラー(unreachable)が発生したこと」にある。Googleの仕様では、robots.txtのステータスによって挙動が明確に異なる。

- 404(Not Found)の場合: クロール制限がないと判断され、インデックスは継続される。

- 5xx系(サーバーエラー等)で到達不能な場合: クロール禁止設定がある可能性を排除できないため、安全策としてサイト全体のクロールが即座に停止される。

Googleサポートが2025年7月23日に公開した動画(Fix 'robots.txt unreachable' Error ~ Website Not Indexing?)内では、以下の点が強調されている。

- robots.txtファイルは、Googlebotが最初に取得を試みる最優先のファイルである。

- このファイルに到達できない(unreachable)場合、Googlebotはそれ以上のクロールを一切行わない。

- 結果として、既存のページはインデックスから削除され、新規ページも登録されず、サイトはGoogle検索上で「不可視」の状態となる。

従来、robots.txtの不在は大きな問題とされてこなかったが、最近のモダンなWebサーバー設定やCDN(Cloudflare等)において、ファイルが存在しないときに「404」ではなく「500エラー」を返してしまう挙動が意図せず増えている。特にアクセス解析を導入していないサイト運営者は、検索結果から消失しても気づくことが遅れるため、Google Search Console等を用いた定期的な監視が不可欠である。

詳細はFix Your robots.txt or Your Site Disappears from Googleを参照していただきたい。