本セッションの登壇者

セッション動画

このセッションでは、Kubernetesの仕組みやそもそも論みたいなところから、デモをまじえてお話ししていきます。

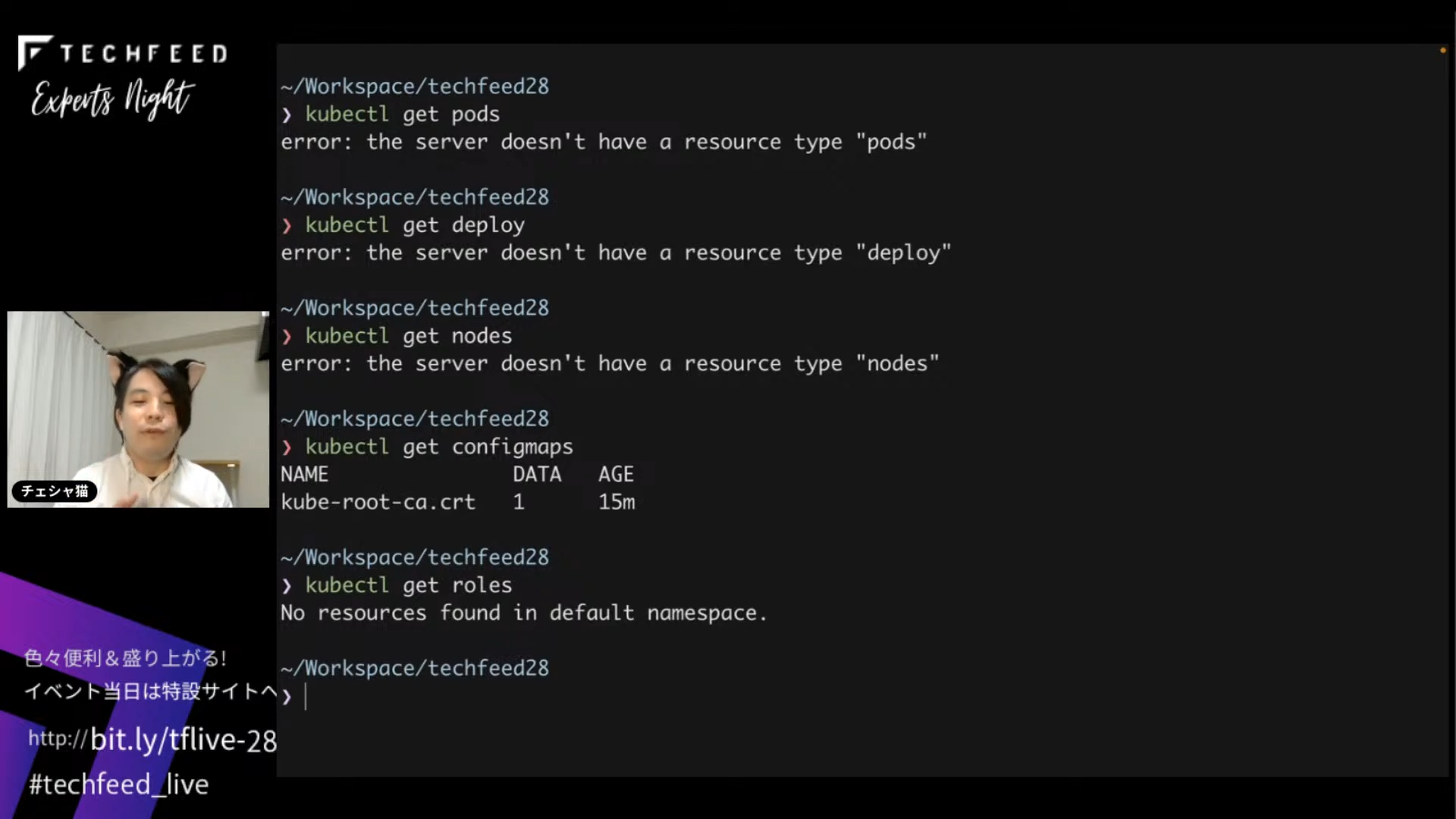

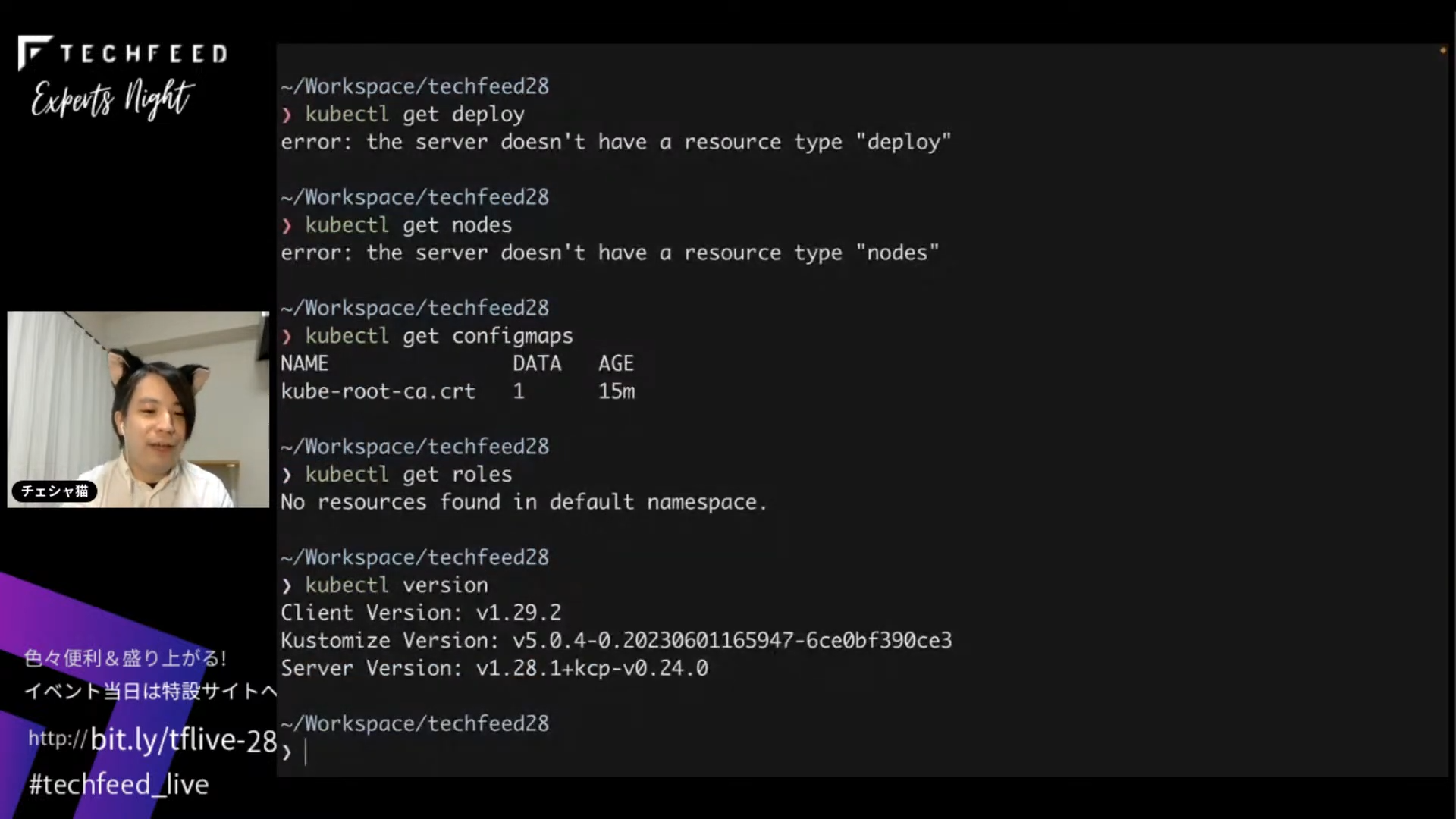

手元に立てたクラスタのデモをお見せします。まず、いくつかコマンドを打つとエラーになります。Kubernetesを触ったことのある方はお気付きだと思いますが、このエラーの出方は非常に奇妙です。なぜなら、PodやDeploymentが何も登録されていない場合であれば、「No resources found(リソースが見つからない)」と言ってくるはずだからです。今回のエラーメッセージは「サーバにそんなリソースタイプが存在しない」なので、接続先の正体は普通のKuberentesではないようです。

ここで、バージョンを見るとその正体が分かります。サーババージョンは1.28.1ですが、+kcpと入っていますね。接続先はこのkcpで、KubernetesのAPIサーバーのようなふりをしながら、Pod、Deployment、Nodeといった実体を持つリソースについては何も知らないという、いわば特殊なクラスタです。今日はこのkcpについてお話しします。

Kubernetes の本質

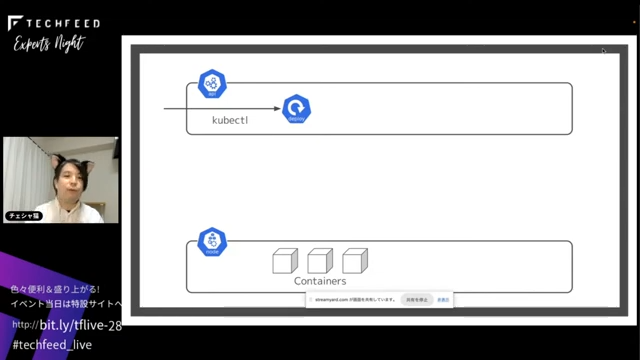

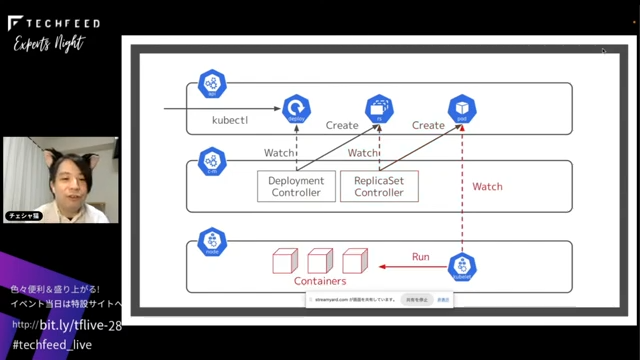

Deploymentを作成した時、表から見るとkubectlをすることでデプロイが行われ、図の下側に書いたノードにコンテナが立つ仕組みになっています。

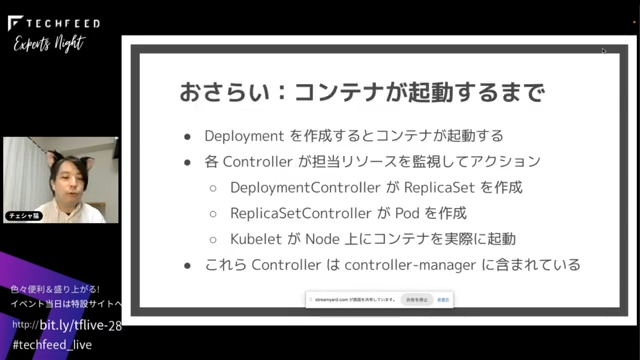

中で何が行われているかをおさらいしておきましょう。内部的には、複数のControllerが担当のリソースを監視してアクションしています。

たとえば、DeploymentControllerはDeploymentをウォッチしていて、DeploymentができたらReplicaSetを作る。ReplicaSetControllerはReplicaSetができたらPodを作る。KubeletはPodができたらコンテナを立てる。そしてデフォルトのControllerはcontroller-managerの中に含まれている、というのが基本的なKubernetesの仕組みです。たとえば、途中でコンテナが1つ足りなくなった、つまりKubeletがPodを見て3つあるはずなのに実際には2つしかない場合は、1個追加で立てようとします。

いわば各Controllerが自分の担当の「何か」を監視して、差分があればリアクティブに「何か」するというのが、Kubernetesの基本的な大原則、一番抽象的な形で語った時の動きの仕組みです。

このことをReconciliation Loopと言います。Reconciliationとはもめごとの仲裁、調停をするという意味です。現状と理想的な状態の間に差が生まれた時に、それを合わせにいく動作がループ的に回っているというのが、Kubernetesの基本的な構造です。

プラットフォームを作るためのプラットフォーム

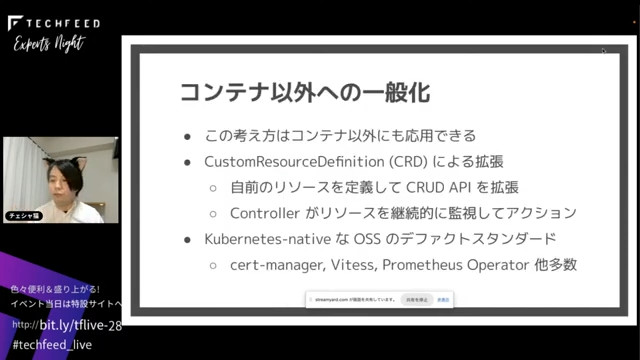

これはコンテナに限った話ではありません。同じ考え方はコンテナ以外にも応用できて、CustomResourceDefinition(CRD)と呼ばれます。KubernetesはCRDによる拡張の仕組みを持っていて、DeploymentやReplicaSetやPod以外にも、自分で好きなリソースとCRUD APIを定義してAPIを増やせる仕組みになっています。自前のリソース用のカスタムコントローラーが自前のリソースを継続的に監視していて、何かあれば対応するアクションを行うという仕組みです。この仕組みはとても広く使われていて、Kubernetes-nativeなOSSのデファクトスタンダードになっています。cert-managerであれば、ロードバランサができた時に対応する証明書をLet's Encryptからもらってきて設定する、Vitessであれば、データベースのインスタンスを管理するというところで、リソースを監視しつつ、継続的にアクションをとる仕組みが生かされているわけです。

このことから、KubernetesはPlatform of Platforms、つまり「プラットフォームを作るためのプラットフォーム」という呼ばれ方をすることがあります。

Controllerの置きどころが悩ましい

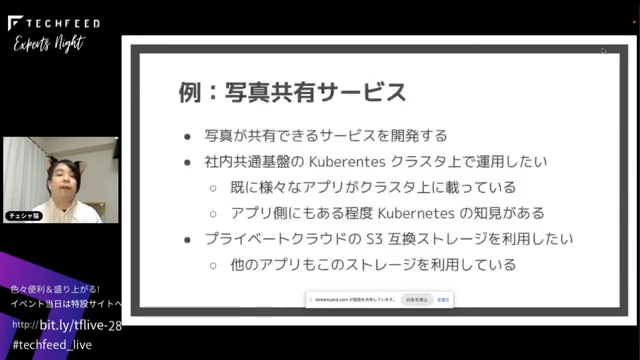

では、これをケーススタディで具体的に見てみましょう。すごく単純化していますが、写真を共有するサービスを展開する例です。すでにいろいろなアプリが載っている社内共通基盤のKubernetesクラスタが存在し、アプリ側もある程度Kubernetes-nativeな書き方の知見はあるとします。プライベートクラウドにある共通基盤のS3互換ストレージを使います。

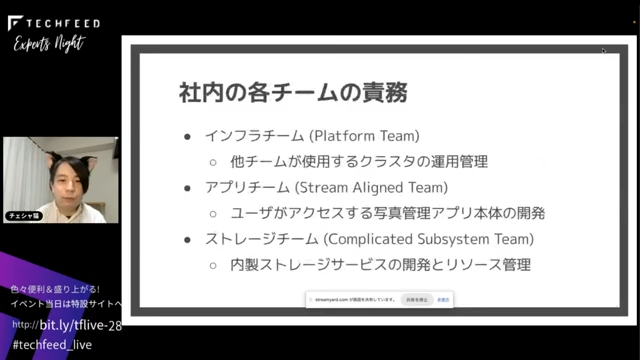

社内チームの責務の構造は図のとおりです。インフラチームがクラスタの管理、アプリチームが写真共有アプリ本体の開発、ストレージチームが内製のストレージサービスの開発と、インスタンスを振り出したり払い出したりするリソース管理をします。書籍『チームトポロジー』の用語で言うと、上から順にPlatform チーム、Stream Aligned チーム、Complicated Subsystemチームという役割に相当します。

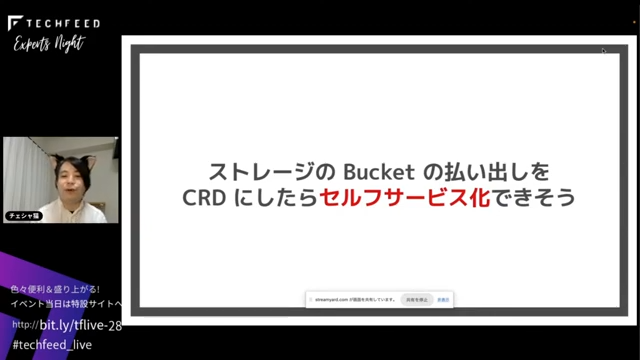

そこで、ストレージのBucketの払い出しをCustomResourceDefinition(CRD)にしたら、kubectlでできるのではないかということで、ここをセルフサービス化していきます。

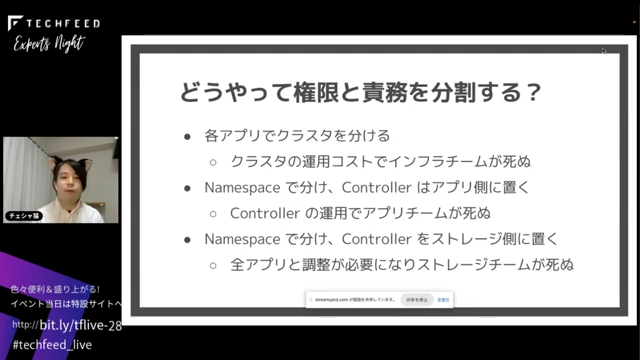

難しいのはControllerの置き方です。権限と責務を分割する際に一番分離度が高いControllerの管理方法としては、アプリごとにクラスタを分けるという手があります。しかし、それをやるとクラスタ数が線形に増えていくので、たいていはインフラチームが死にます。もう少し穏当な方法だと、KubernetesはNamespaceで分割する機能を持っているので、Namespaceでチームごとに分けて、Controllerはアプリ側に置けます。ただ、そうするとアプリ側がControllerの運用をやることになるのでアプリチームが死ぬ。では、Namespaceを分けて、Controllerはストレージチームが管理することにすると、Controllerのバージョンアップなどの際に全アプリと調整する必要が出てきて、調整コストでストレージチームが死ぬ。

結論としては、誰かが死にます。

こういった問題意識のもとに現れたのが、今回紹介するkcpです。

kcpは2023年9月にCNCFで3段階ある一番下の成熟度のSandboxに入りました。最初のデモでお見せしたように、kcpはKubernetesのAPIサーバーのように振る舞う「何か」です。

またkcpについては先日のKubeCon EU 2024でも発表されました。

APIプラットフォームのためのフレームワーク

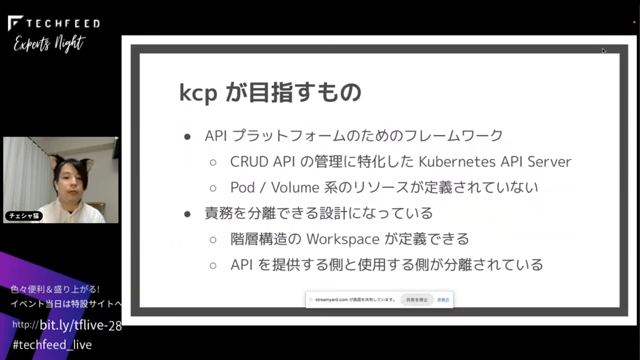

kcpの目指すものは、APIプラットフォームを作るためのフレームワークです。CRUD APIの管理だけに特化したAPIサーバーだと考えることができ、Pod やVolume、Nodeなどのいわゆるコンピューティングの実体を持つリソースは定義されていません。逆に何があるのかというと、責務を分離できる設計になっています。大きくは2つ機能があって、階層構造のワークスペースが定義できることが一つ、もう一つは、APIを提供する側と使用する側で分離して、別々のリソースを割り当てることができる仕組みになっています。

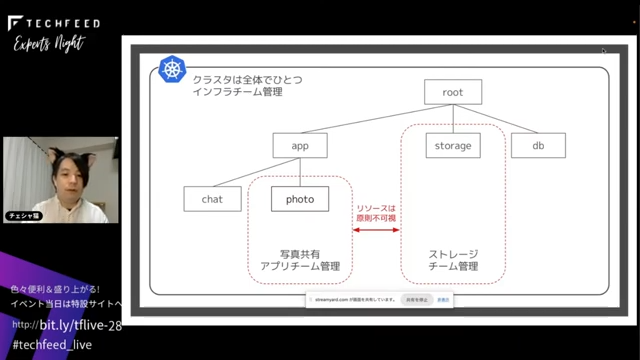

図解するとこのようになります。複数チームで1つのクラスタをインフラチームが管理し、ツリー構造に root があって、app があって、その下にチャットアプリと写真共有アプリがあって、rootの直下にストレージとDBチームがあるとします。kcpが提供するのは赤で表示された部分です。占有領域で囲われたところにデプロイされたリソースは原則不可視になります。

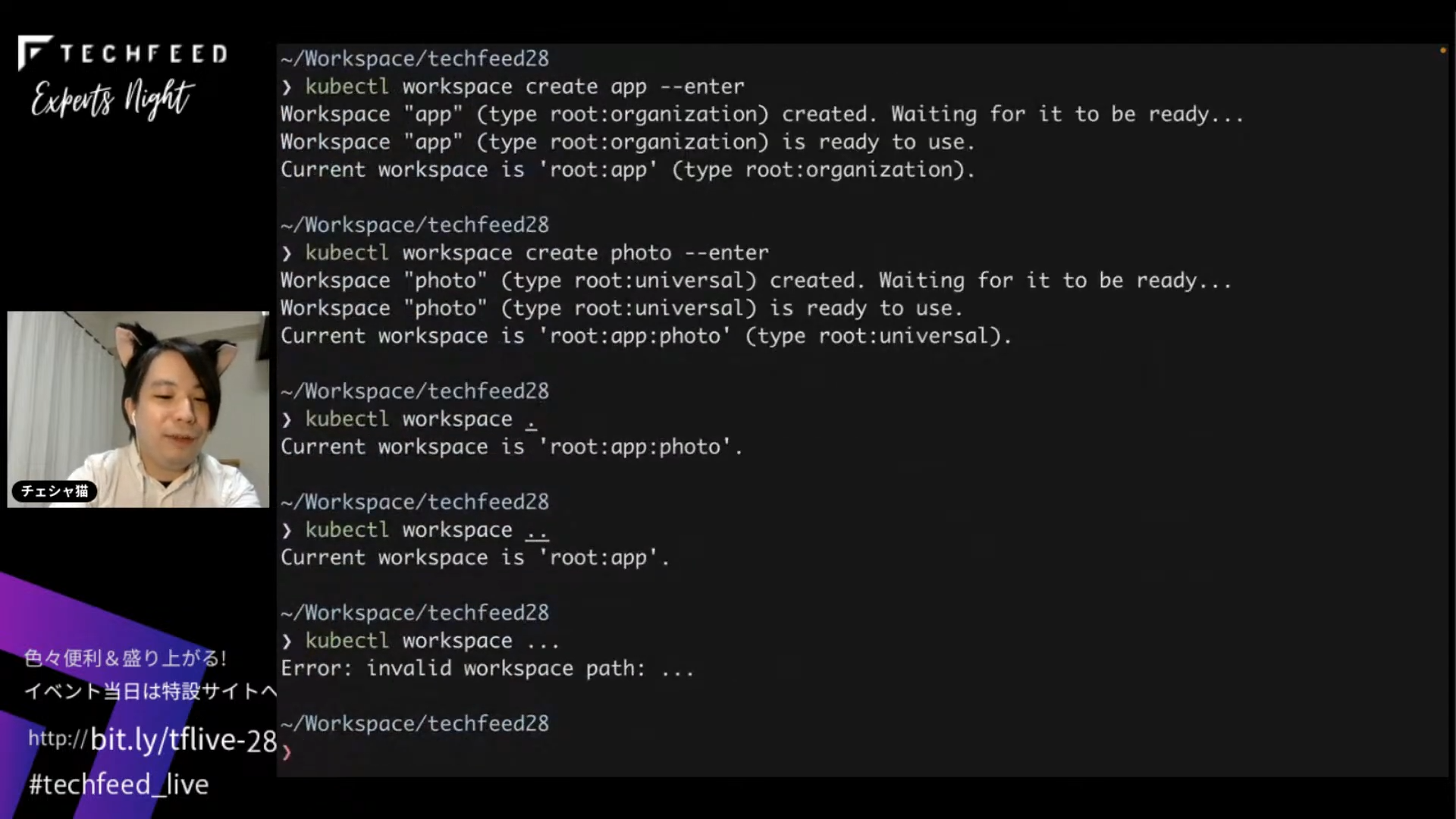

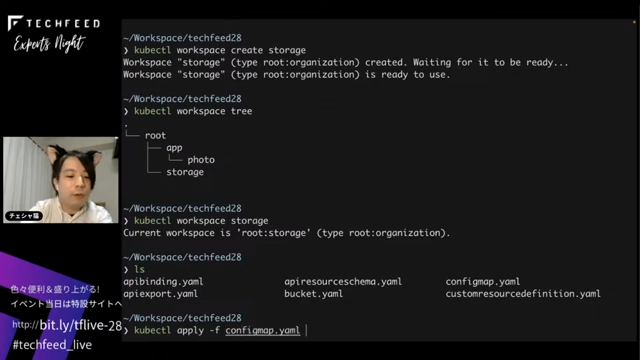

デモで見てみます。kubectlのプラグインとして機能が提供されていて、workspaceというサブコマンドを入力すると今rootにいることが分かります。たとえば、kubectl workspace create appと入力するとappが作成されます。同様にphotoも作成します。戻ってrootにstorageを作成します。このようにツリー構造を定義できます。

実際に定義されたものはこのようになります。ここから storage の中で適当なconfigmapを作ったとすると、使う側のphoto Workspaceからはconfigmapは見えません。

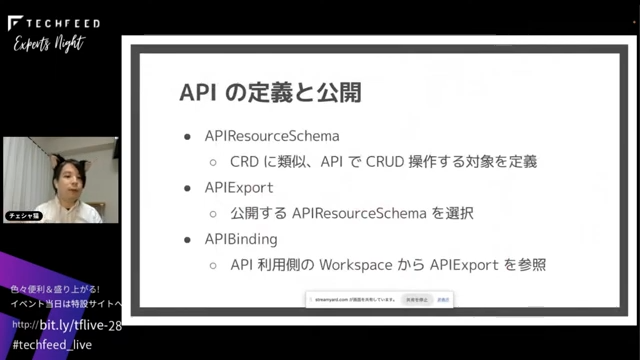

提供する側と使う側の分離についてですが、kcpには APIResourceSchema、APIExport、APIBinding の3つがあります。たとえばBucket作成APIを定義する側のストレージチームがstorage WorkspaceにAPIResourceSchemaの定義を置き、APIExportによってそれを参照します。使う側はAPIBindingを定義してAPIExportを参照し、最終的にkubectlでBucketが作成できるようになるという仕組みになっています。おもしろいのはAPIResourceSchemaとAPIExportが分かれていることによって、複数バージョンのControllerをデプロイすることができるので、APIの実体とゲートウェイみたいな形でバージョンの管理ができることです。今は実装されていませんが、後々ブルーグリーンやローリングアップデートなども定義される予定です。

まとめです。Kubernetesはコンテナに留まらない基盤になっています。実際の操作方法としては、CustomResourceに対するReconciliationを行います。ただ、これをやると、特に今回の例のようにインフラ・アプリ以外に共通サービスチームがある時などにControlerの置き所に困ります。この問題を解決するために、kcpはAPIプラットフォームの構築に特化していて、APIを公開する側と使用する側で、リソース的にもバージョン的にも分離できる仕組みを提供しています。

この仕組みによって、kcpはただのプラットフォームのためのプラットフォームから一歩進んで、APIのためのプラットフォームを目指しているプロダクトである、というのが今回のお話でした。ありがとうございました。

You make so many great points here that I read your article a couple of times. Your views are in accordance with my own for the most part. This is great content for your readers. spoof hwid

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. bandar toto

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. hptoto slot

I am impressed. I don't think Ive met anyone who knows as much about this subject as you do. You are truly well informed and very intelligent. You wrote something that people could understand and made the subject intriguing for everyone. Really, great blog you have got here. blood bank serofuge

When your website or blog goes live for the first time, it is exciting. That is until you realize no one but you and your. tube strippers

I have read all the comments and suggestions posted by the visitors for this article are very fine,We will wait for your next article so only.Thanks! paito sydney lotto

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. sydney lotto

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. togel taiwan

I think this is an informative post and it is very useful and knowledgeable. therefore, I would like to thank you for the efforts you have made in writing this article. miototo

I think this is an informative post and it is very useful and knowledgeable. therefore, I would like to thank you for the efforts you have made in writing this article. toto slot

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. miototo

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. hargatoto

I have read all the comments and suggestions posted by the visitors for this article are very fine,We will wait for your next article so only.Thanks! olxtoto

hi was just seeing if you minded a comment. i like your website and the thme you picked is super. I will be back. 加拿大寄香港

I have read all the comments and suggestions posted by the visitors for this article are very fine,We will wait for your next article so only.Thanks! mawartoto

Wow! This could be one of the most useful blogs we have ever come across on thesubject. Actually excellent info! I’m also an expert in this topic so I can understand your effort. situs mawartoto

I have read all the comments and suggestions posted by the visitors for this article are very fine,We will wait for your next article so only.Thanks! olxtoto

Excellent article. Very interesting to read. I really love to read such a nice article. Thanks! keep rocking. Affordable security guards Philippines

Excellent article. Very interesting to read. I really love to read such a nice article. Thanks! keep rocking. link slot

Excellent article. Very interesting to read. I really love to read such a nice article. Thanks! keep rocking. วิเคราะห์บอล zeanstep

Really I enjoy your site with effective and useful information. It is included very nice post with a lot of our resources.thanks for share. i enjoy this post. agglutination viewer

Regarder la TV en direct sur IPTV Smarters Pro est une expérience fluide et immersive. Cette application intuitive permet d’accéder à des centaines de chaînes en direct, que ce soit pour les actualités, le sport, les films ou les émissions internationales. Elle est compatible avec plusieurs appareils, dont Smart TV, Android, iOS et PC. Grâce à sa qualité de streaming HD et ses fonctions avancées, elle transforme votre façon de regarder la télévision en toute simplicité Regarder la TV en direct sur IPTV Smarters Pro

Some truly wonderful work on behalf of the owner of this internet site , perfectly great articles . Erome

Thank you for some other informative blog. Where else could I get that type of information written in such an ideal means? I have a mission that I’m just now working on, and I have been at the look out for such information. 해외선물 임대

I was reading your article and wondered if you had considered creating an ebook on this subject. Your writing would sell it fast. You have a lot of writing talent. magnumslot

You there, this is really good post here. Thanks for taking the time to post such valuable information. Quality content is what always gets the visitors coming. bola88

Remarkable article, it is particularly useful! I quietly began in this, and I'm becoming more acquainted with it better! Delights, keep doing more and extra impressive! 해외선물 분양

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... agenolx link alternatif

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... olxtoto togel

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... malaga airport taxi

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... toto macau

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... سایت شرط بندی پاسور چهار برگ

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... result macau 4d

It is a great website.. The Design looks very good.. Keep working like that!. dewatogel login

I havent any word to appreciate this post.....Really i am impressed from this post....the person who create this post it was a great human..thanks for shared this with us. Alexistogel

Really I enjoy your site with effective and useful information. It is included very nice post with a lot of our resources.thanks for share. i enjoy this post. www.KatieFloyd.me

Really I enjoy your site with effective and useful information. It is included very nice post with a lot of our resources.thanks for share. i enjoy this post. www.binance-us.net

When you use a genuine service, you will be able to provide instructions, share materials and choose the formatting style. Pusat4D

I really appreciate the kind of topics you post here. Thanks for sharing us a great information that is actually helpful. Good day! olxtoto alternatif I really appreciate the kind of topics you post here. Thanks for sharing us a great information that is actually helpful. Good day! situs togel 4d I really appreciate the kind of topics you post here. Thanks for sharing us a great information that is actually helpful. Good day! toto togel I really appreciate the kind of topics you post here. Thanks for sharing us a great information that is actually helpful. Good day! situs terpercaya I really appreciate the kind of topics you post here. Thanks for sharing us a great information that is actually helpful. Good day! toto togel paito warna sgp

I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. agenolx link alternatif

I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. olxtoto alternatif I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. situs togel 4d I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. togel 4d I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. situs terpercaya I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. togel 4d paito togel sgp

I just couldn't leave your website before telling you that I truly enjoyed the top quality info you present to your visitors? Will be back again frequently to check up on new posts. www.uniswap-exchange.cx

I just couldn't leave your website before telling you that I truly enjoyed the top quality info you present to your visitors? Will be back again frequently to check up on new posts. uniswap exchange

I just couldn't leave your website before telling you that I truly enjoyed the top quality info you present to your visitors? Will be back again frequently to check up on new posts. www.uniswap.us.com

I just couldn't leave your website before telling you that I truly enjoyed the top quality info you present to your visitors? Will be back again frequently to check up on new posts. bandar toto macau

Kantorbola link alternatif daftar dan login resmi situs kantorbola terbaru . Gunakan link alternatif terbaru untuk akses mudah ke permainan. kantorbola login

You delivered such an impressive piece to read, giving every subject enlightenment for us to gain information. Thanks for sharing such information with us due to which my several concepts have been cleared. Casino trực tuyến

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... situs slot gacor

I’m going to read this. I’ll be sure to come back. thanks for sharing. and also This article gives the light in which we can observe the reality. this is very nice one and gives indepth information. thanks for this nice article... boutiq carts

Pretty good post. I just stumbled upon your blog and wanted to say that I have really enjoyed reading your blog posts. Any way I'll be subscribing to your feed and I hope you post again soon. Big thanks for the useful info. criminal defense attorneys near me

Pretty good post. I just stumbled upon your blog and wanted to say that I have really enjoyed reading your blog posts. Any way I'll be subscribing to your feed and I hope you post again soon. Big thanks for the useful info. xiaomi mi lock remove

Thanks for a very interesting blog. What else may I get that kind of info written in such a perfect approach? I’ve a undertaking that I am simply now operating on, and I have been at the look out for such info. criminal defense lawyer near me

Excellent article. Very interesting to read. I really love to read such a nice article. Thanks! keep rocking. how to remove Xiaomi account

Thanks for a very interesting blog. What else may I get that kind of info written in such a perfect approach? I’ve a undertaking that I am simply now operating on, and I have been at the look out for such info. GullyBet news updates

Thanks for a very interesting blog. What else may I get that kind of info written in such a perfect approach? I’ve a undertaking that I am simply now operating on, and I have been at the look out for such info. GullyBet promotions

I admit, I have not been on this web page in a long time... however it was another joy to see It is such an important topic and ignored by so many, even professionals. I thank you to help making people more aware of possible issues. login kantorbola I admit, I have not been on this web page in a long time... however it was another joy to see It is such an important topic and ignored by so many, even professionals. I thank you to help making people more aware of possible issues. bandar toto macau I admit, I have not been on this web page in a long time... however it was another joy to see It is such an important topic and ignored by so many, even professionals. I thank you to help making people more aware of possible issues. commercial pest control dallas I admit, I have not been on this web page in a long time... however it was another joy to see It is such an important topic and ignored by so many, even professionals. I thank you to help making people more aware of possible issues. mckinney hair salon I admit, I have not been on this web page in a long time... however it was another joy to see It is such an important topic and ignored by so many, even professionals. I thank you to help making people more aware of possible issues. ai staffing it recruiting

When you use a genuine service, you will be able to provide instructions, share materials and choose the formatting style. login kantorbola When you use a genuine service, you will be able to provide instructions, share materials and choose the formatting style. bandar toto macau When you use a genuine service, you will be able to provide instructions, share materials and choose the formatting style. commercial exterminators When you use a genuine service, you will be able to provide instructions, share materials and choose the formatting style. mckinney hair salon When you use a genuine service, you will be able to provide instructions, share materials and choose the formatting style. ai staffing it recruiting

Great survey, I'm sure you're getting a great response. situs toto Great survey, I'm sure you're getting a great response. koitoto Great survey, I'm sure you're getting a great response. olxtoto login Great survey, I'm sure you're getting a great response. agen togel Great survey, I'm sure you're getting a great response. koitoto agen slot resmi

It is the kind of information I have been trying to find. Thank you for writing this information. It has proved utmost beneficial for me. situs olxtoto

Akses Mudah & Gratis Tidak perlu daftar atau login rumit. Cukup kunjungi situs OLXTOTO, dan semua data paito langsung tersedia untuk Anda gunakan. paito sgp lotto

Your articles are inventive. I am looking forward to reading the plethora of articles that you have linked here. Thumbs up! situs toto slot

I definitely enjoying every little bit of it. It is a great website and nice share. I want to thank you. Good job! You guys do a great blog, and have some great contents. Keep up the good work. agenolx terpercaya

I visit your blog regularly and recommend it to all of those who wanted to enhance their knowledge with ease. The style of writing is excellent and also the content is top-notch. Thanks for that shrewdness you provide the readers! olxtoto togel

Thank you for taking the time to publish this information very useful! rajabandot

Thank you for taking the time to publish this information very useful! koi toto Thank you for taking the time to publish this information very useful! olxtoto link Thank you for taking the time to publish this information very useful! togel online Thank you for taking the time to publish this information very useful! live casino Thank you for taking the time to publish this information very useful! olxtoto toto togel

Thank you for taking the time to publish this information very useful! manaplay Thank you for taking the time to publish this information very useful! situs toto Thank you for taking the time to publish this information very useful! olxtoto link alternatif Thank you for taking the time to publish this information very useful! pestoto login Thank you for taking the time to publish this information very useful! agen togel bandar togel

I am impressed. I don't think Ive met anyone who knows as much about this subject as you do. You are truly well informed and very intelligent. You wrote something that people could understand and made the subject intriguing for everyone. Really, great blog you have got here.

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Click Here

Great job for publishing such a beneficial web site. Your web log isn’t only useful but it is additionally really creative too. https://withdrawmiers.org/

Very useful info. Hope to see more posts soon!. 037hd.id

Very useful post. This is my first time i visit here. I found so many interesting stuff in your blog especially its discussion. Really its great article. Keep it up. m the thao

I was reading some of your content on this website and I conceive this internet site is really informative ! Keep on putting up. A-1 Service Group

Wow, cool post. I'd like to write like this too - taking time and real hard work to make a great article... but I put things off too much and never seem to get started. Thanks though. Binary Options

With thanks just for offer a very awesome page! I stubled onto a web site ideal for great really needs. Its content has delightful and additionally important reports. Preserve acknowledge that there are succeed! 서울 사업자 대출

Positive site, where did u come up with the information on this posting?I have read a few of the articles on your website now, and I really like your style. Thanks a million and please keep up the effective work. slot pulsa 5000

Positive site, where did u come up with the information on this posting?I have read a few of the articles on your website now, and I really like your style. Thanks a million and please keep up the effective work. slot pulsa 5000

Positive site, where did u come up with the information on this posting?I have read a few of the articles on your website now, and I really like your style. Thanks a million and please keep up the effective work. slot pulsa 5000

Your blog is too much amazing. I have found with ease what I was looking. Moreover, the content quality is awesome. Thanks for the nudge! 기업 대출

That is the nice tips and hints certainly towards some of those having their first go blogosphere, temporary not to mention adequate information… Thanks a lot for the purpose of showing gas 4 free :. Vital read through piece of writing. Loft conversions Surbiton

Excellent Submit, I will be a huge believer inside submitting feedback about web sites to be able to allow the website copy writers understand that they’ve extra one thing useful to be able to the net! funny slutty panties

Excellent Submit, I will be a huge believer inside submitting feedback about web sites to be able to allow the website copy writers understand that they’ve extra one thing useful to be able to the net! Winter Park Top rated personal trainer