4月11日、Metaは次世代のAI専用インフラストラクチャについて、同社の独自チップ「MTIA」の新バージョン、そして同社のAIインフラの将来について述べたブログを公開した。

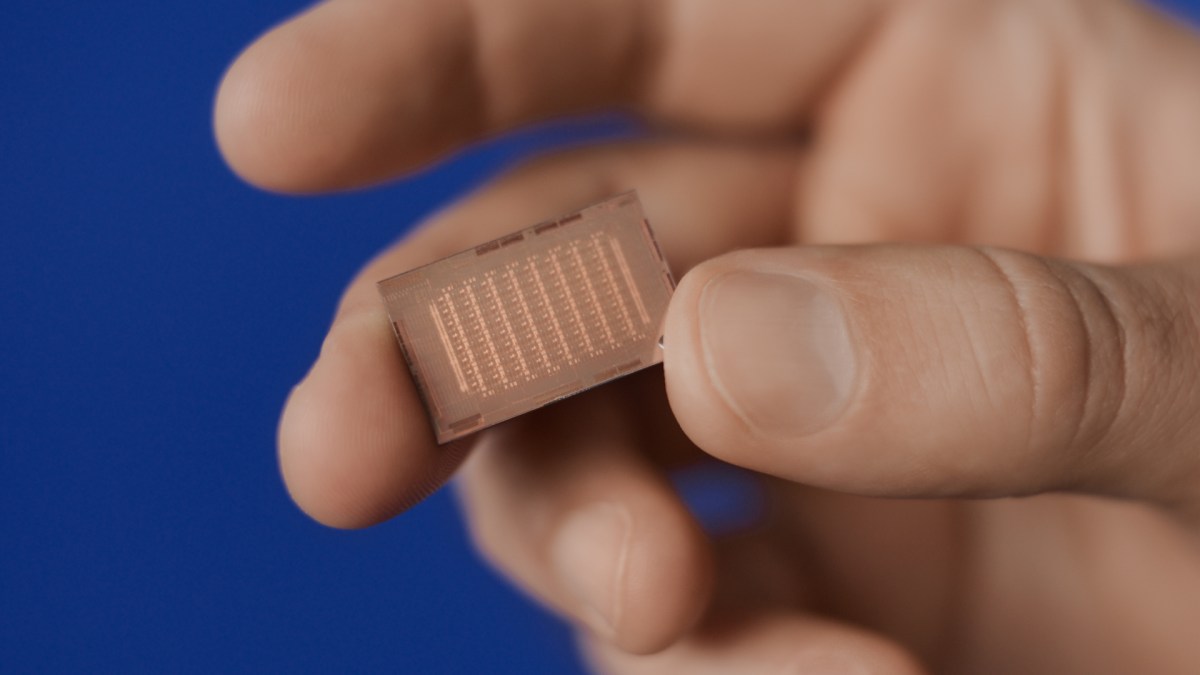

昨年、Metaは独自に設計した第一世代AI推論アクセラレータである Meta Training and Inference Accelerator(MTIA)v1 を発表した。これはMetaが提供するサービスで利用する、大規模な深層学習推薦モデルに特化して設計されたもの である。

MTIAは、Metaのサービス独自の要件に特化し、最も効率的なアーキテクチャを提供することを目的としている。このチップは実際にMetaのデータセンターに配備されており、市販のGPUに比べても高い効率を実現しているという。

今回発表された情報によると、MTIAの新バージョンは、 計算能力とメモリ帯域を2倍以上に向上 させ、高品質なレコメンデーションをユーザーに提供するための、ランキングおよび推薦モデルに効率的に対応するよう設計されている。

Metaは、MTIAで構築されたAIインフラと既存のインフラと連携させる設計を進めており、将来的には次世代GPUを含むより高度なハードウェアの利用も検討しているという。

この新しいシステムは、AIモデルの計算要件と複雑さが増すにつれて、今後数年間での投資拡大が見込まれる。特に、新たな生成AI製品、推薦システム、および先進的なAI研究を支援することを目的としている。生成AIのサポートなど、MTIA の範囲を拡大することを目的としたいくつかのプログラムも進行中で、同社によれば「まだ旅は始まったばかり」だという。

詳細はIntroducing Our Next Generation Infrastructure for AIを参照されたい。

This is very interesting information! I liked reading them and agree with many of them shell shockers